Главная

»

Самолетостроение

»

Теория информационных процессов и систем

»

Энтропия источника дискретных сообщений. Энтропия источника зависимых сообщений.

Энтропия источника дискретных сообщений. Энтропия источника зависимых сообщений.

Энтропия источника дискретных сообщений.

Важной характеристикой информации являются среднее кол-во информации, приходящееся на одно сообщение. Если сообщения равновероятны, то количество информации в каждом из них одинакова, то эта величина рассчитывается.

Однако сообщения как правило имеют разную вероятность. В сообщении необходимо иметь сведения о вероятности каждого сообщения.

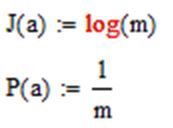

Энтропией называется среднее количество информации приходящееся на одно сообщение источника как математическое ожидание J(ai) ____

H(a)=J(ai)

Максимальная энтропия имеет место при р=0,5

Среднее кол-во информации в одном сообщении равно Jn=nH(a)

Свойства энтропии

1.Величина всегда положительная

2.Энтропия всегда максимальна при равновероятных сообщениях

Энтропия источника зависимых сообщений.

Статистическая связь определенного сообщения с предыдущим оценивается с совместной вероятностью.

Р(ак;al)

Или с условной вероятностью Р(al/ak)

где

Al появившееся сообщение

Ak предыдущее сообщение

Кол-во информации в сообщении при условии что известно предыдущее сообщение Ак

J(al/ak)=-logP(al/ak)

Среднее кол-во информации при этом определяется условной энтропией Н(al/ak)

Наличие статических связей между сообщениями всегда приводит к уменьшению кол-ва информации приходящейся в среднем на одно сообщение.

Друзья! Приглашаем вас к обсуждению. Если у вас есть своё мнение, напишите нам в комментарии.